長原 一

副拠点長/教授/PI

大阪大学データビリティフロンティア機構

- 関連ウェブサイト:

- 研究室ウェブサイト research gate researchmap

PRIMeの研究者

PRIMeでは、多様な分野、国籍、背景を持つ研究者がアンダーワンルーフで混ざり合い、学際的・統合的な研究ができる研究環境を醸成していきます。

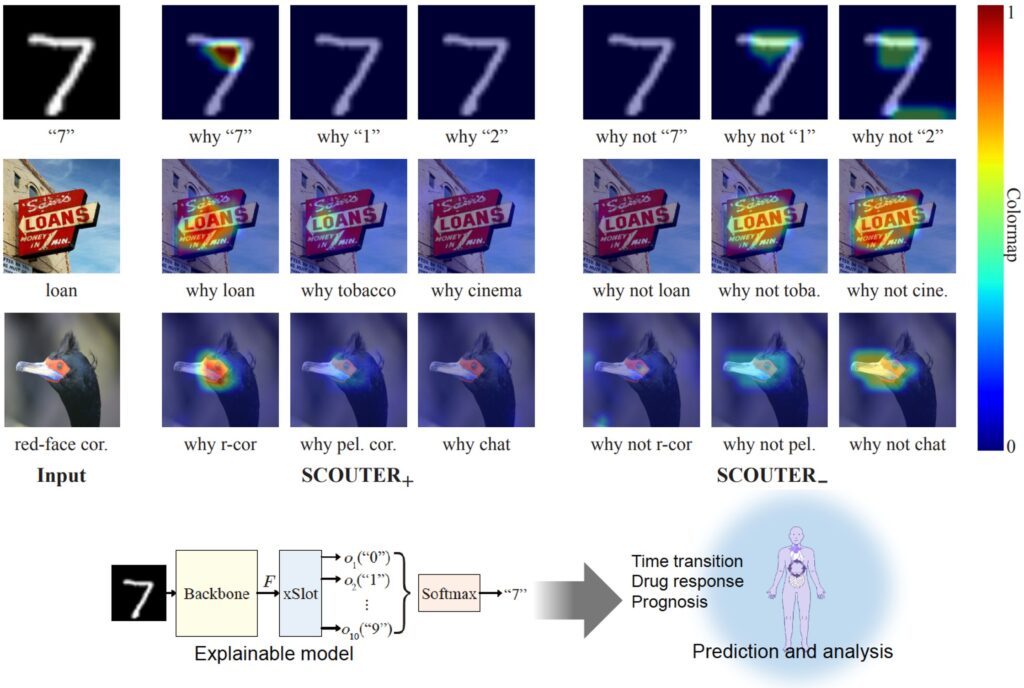

ヒューマンメタバースのための説明可能AI

深層学習(ディープラーニング)は,科学や医学のデータ解析や予測をするモデリングツールとして注目されている.しかしながら,深層学習モデルのブラックボックスの特徴により,その解析が難しいことが問題としてあげられている.我々はこの問題に大してさまざまな応用分野に対して説明可能なAIモデルの研究をおこなっている.このプロジェクトでは,バイオイメージ画像認識や生体のモデリングにおいて接系可能なAIモデルを適用する.

研究概要

我々は,画像認識問題において説明可能なAIモデルについて研究を行ってきた.提案した説明可能モデルSCOUTERでは,画像のどの部分の画像特徴が識別の判断に重要であったかを可視化できるモデルである.下記の例で示すように,例えば手書き文字認識において,“7”であると判断した特徴や逆に“1”ではない,負の判断に用いられた画像特徴の重要度をヒートマップとして表示している.このように,モデルの判断結果だけでなくその判断に使われた特徴の場所を可視化することで,人間の直感にそった判断をしているかを理解できる.このような説明可能AI技術を本プロジェクトで使うバイオや医療情報のモデリングに用いる.

参考文献

Liangzhi Li, Bowen Wang, Manisha Verma, Yuta Nakashima, Ryo Kawasaki, Hajime Nagahara, “SCOUTER: Slot attention-based classifier for explainable image recognition”, International Conference on Computer Vision, Oct., 2021.